大数据课程 实时计算框架之软件安装篇

Spark的安装与配置

希望可以做到让你直接复制粘贴就能完成学校的实验

1.Spark单机模式安装

tar -zxvf spark-2.1.0-bin-hadoop2.7.tgzmv spark-2.1.0-bin-hadoop2.7 /opt/spark-2.1.0vim /etc/profile#spark install

export SPARK_HOME=/opt/spark-2.1.0

export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbinsource /etc/profileSpark Standalone模式部署

cd $SPARK_HOME/confcp spark-env.sh.template spark-env.shvim spark-env.sh拉到最下面添加

export JAVA_HOME=/usr/java/jdk1.8.0_361

export SPARK_MASTER_HOST=hmbb1

export SPARK_MASTER_PORT=7077cp slaves.template slavesvim slaves拉到最下面添加(记得删了localhost)

hmbb2

hmbb3cp spark-defaults.conf.template spark-defaults.conf在hmbb1上

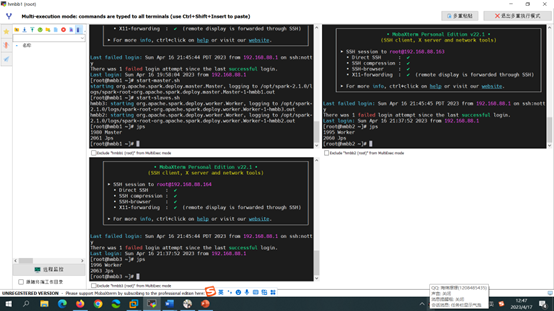

start-master.sh

start-slaves.sh然后三台一起jps

Spark On Yarn模式部署

vim /opt/spark-2.1.0/conf/spark-env.sh在末尾添加: export HADOOP_CONF_DIR=/opt/hadoop/etc/hadoop

vim /opt/hadoop-2.7.7/etc/hadoop/yarn-site.xml在里面添加:

<property>

<name>yarn.nodemanager.pmem-check-enabled</name>

<value>false</value>

</property>

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>开启Hadoop集群(仅在1执行)

start-dfs.shstart-yarn.sh运行一个例子

spark-submit \

--class org.apache.spark.examples.SparkPi \

--master yarn \

--deploy-mode client \

--executor-memory 1G \

--num-executors 10 \

/opt/spark-2.1.0/examples/jars/spark-examples_2.11-2.1.0.jar \

100